基礎研究 ~新しい人工知能(AI)をめざして~

人々は古代より知にあこがれ、生活を便利にする道具や機械を発明し、また、さまざまな学問を発展させてきました。人工知能(AI: Artificial Intelligence)は、コンピュータの発明に触発され電子頭脳の構築をめざす研究として始まりました。

この人工知能は、下のような経緯をたどっています。

第1回AIブーム: 推論と探索の時代 1956年−1974年

第2回AIブーム: 知識工学の時代 1980年–1987年

第3回AIブーム: ディープラーニングの時代 2006年−

(Wikipediaによる)

ディープラーニングとは深層学習であり、多層ニューラルネットワークの学習です。今回のAIブームは、“ディープラーニングの時代”とあるように、人間の脳に学ぼうとするニューラルネットワーク研究の成果によるものです。これまでの論理的な推論や前世紀の知識工学とは全く異なる技術によるものです。

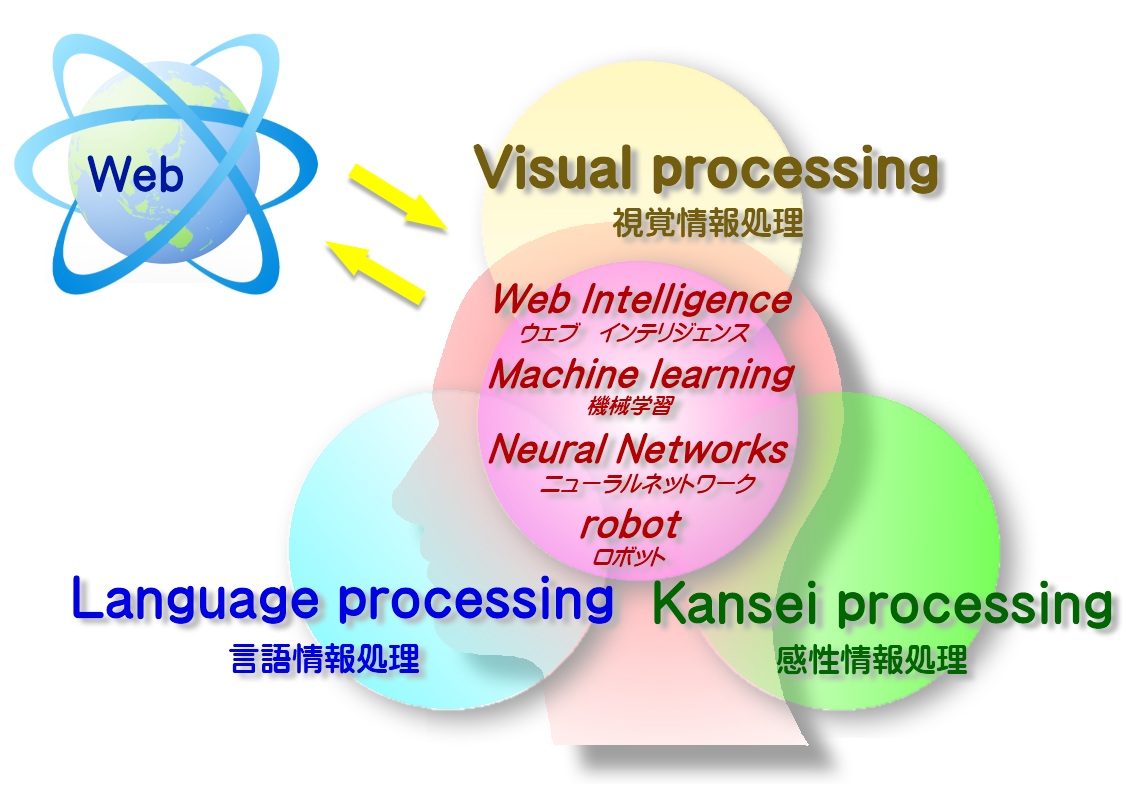

萩原研究室では、これからの情報処理は脳に学ぶべきとの考えから1989年頃よりニューラルネットワークの研究を続けており、多くの研究成果をあげて来ました。

世の中では特にGoogleやFacebookなどのGAFAが、膨大なデータや計算資源を使って画像認識、画像生成、囲碁、機械翻訳などの分野で数々の成果をあげています。ところが、例えばAlphaGoではCPU1202個、GPU176基のコンピュータ資源で学習が行われたと言われています。このような計算環境を一般ユーザに求めるのは不可能です。またAmazonが有するような膨大なデータ量で学習を行うのも、GAFAと一部の組織以外ではほとんど不可能です。

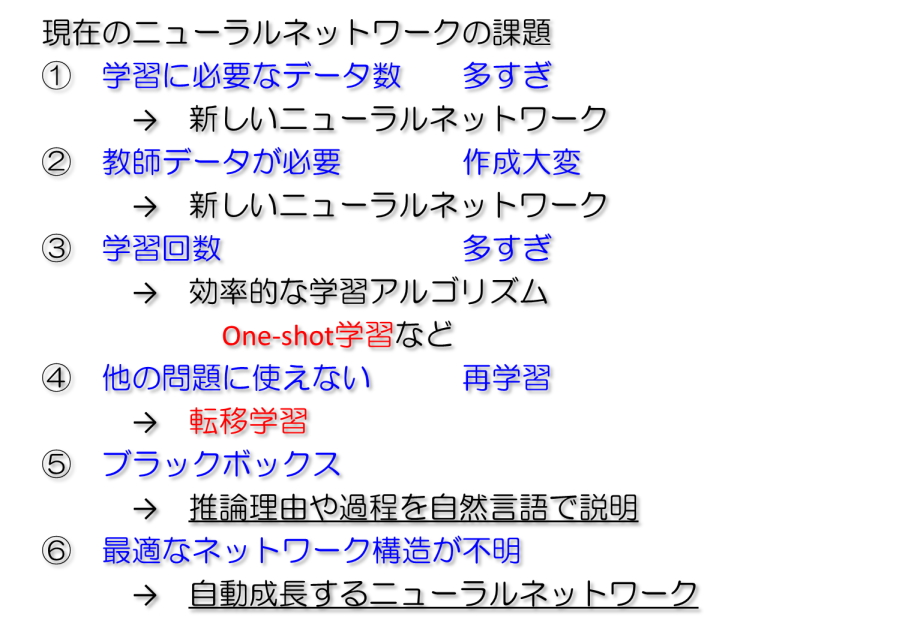

AIつまりニューラルネットワークが世の中で広く普及されるためには、右図のような問題点を克服する必要があります。

萩原研究室では、このようなニューラルネットワークの根本的な問題を解決する研究に力を入れています。そして、人と心地よく共生できる知的で親切なシステムの構築をめざしています。

① 学習に必要なデータ数 多すぎ

② 教師データが必要 作成大変

③ 学習回数 多すぎ

ニューラルネットワークは、明らかな知識がある場合でも、膨大な数の「データ-答え」のペアを与えることにより学習が行われます。知識とデータを統一的に学習できるアルゴリズムの開発が大切です。萩原研究室では、明らかな知識をニューラルネットワークに取り組む研究を行っています。その成果の一つが、↓です。

Hiroshi Honda, Masafumi Hagiwara: “Question Answering Systems with Deep Learning-Based Symbolic Processing,” IEEE Access, Vo.7, pp.1152368-152378, 2019.

⑤ ブラックボックス

に関しては、現在、修士の学生さんの研究が進んでいて、すばらしい研究成果が出始めています。

12月の学会で発表予定です。

⑥ 最適なネットワーク構造が不明

に関してはまず、自動的に成長するニューラルネットワークを開発しました。↓

佐々木駿也,萩原将文:“動的多層化ニューラルネットワーク,”電子情報通信学会論文誌(D), Vol. J102-D, No.3, pp.226-234, 2019.

研究内容

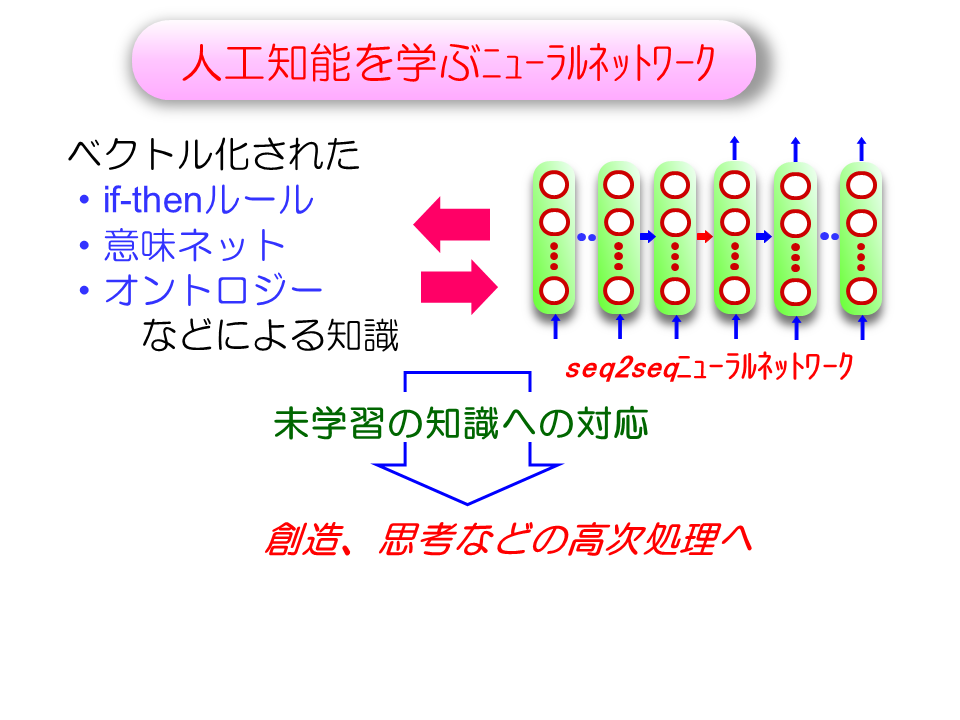

人工知能を学ぶニューラルネットワーク

従来の人工知能には、未学習な状況には全く対応できないという大きな問題点がありました。単語をベクトル表現するword2vecという手法があります。これにより知識をベクトル表現することが可能になりました。そこでベクトル表現された知識をseq2seq型のニューラルネットワークで処理する研究を行っています。未知な単語や知識があっても、ベクトル表現されているので類似した知識を想起し、処理することが可能です。

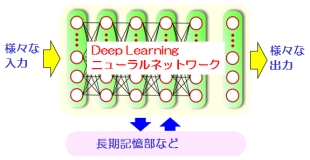

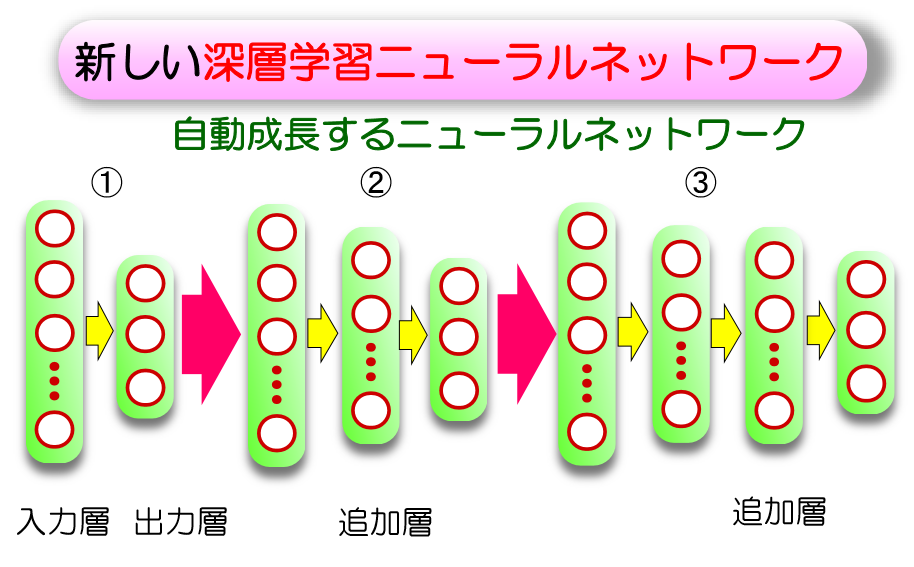

自動成長するニューラルネットワーク

これまでのニューラルネットワークは基本的にモデルの形状は固定されており、学習のさい構造が変化するということはありません。

しかし、われわれ人間は何かを学習する際、最初は単純、大雑把にある事柄を学び、そのあとで徐々に複雑で細かい事柄を学んでいきます。

このことを考慮して、学習が進むにつれて層の数を動的に増やしていき複雑な事柄を段階的に学習していくという、新たな深層学習のモデルを現在研究しています。

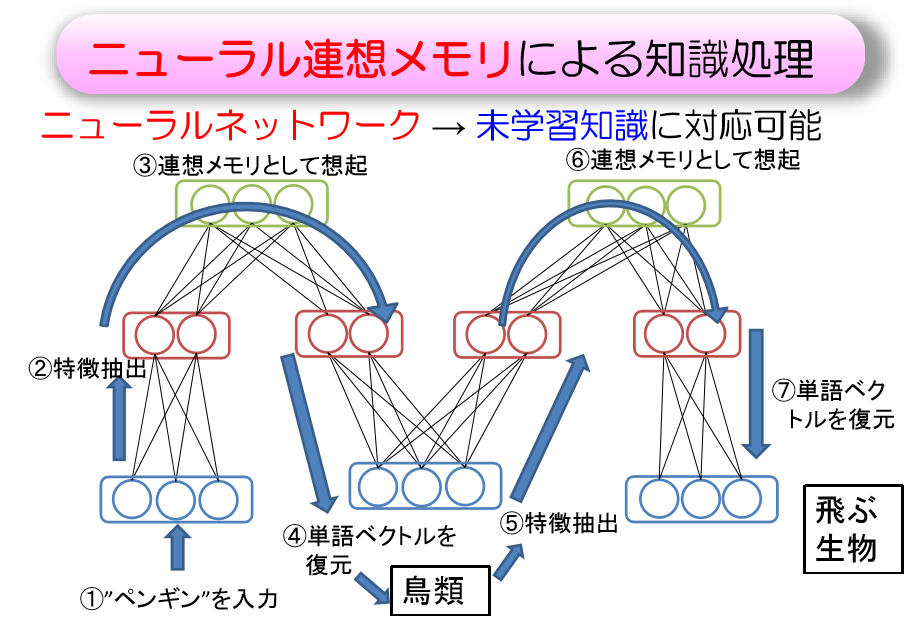

RBM(制約ボルツマンマシン)を用いた連想記憶

連想記憶とは、ある事柄から別の事柄を「連想」するという人間の知識処理の最も根幹にあたる部分をモデル化したものです。

例えば、「りんご」という入力が与えられると、そこから「果物」や「バナナ」といった意味的に関連する単語を連想し、それを出力します。

この研究では、ニューラルネットワークの一手法であるRBM(Restricted Boltzmann Machine; 制約ボルツマンマシン)を使ってこの連想記憶を実現することを試みています。

さらに、この研究の応用として、人間が持つ意味の関係性をネットワークの形でモデル化しようという研究も現在行っています。

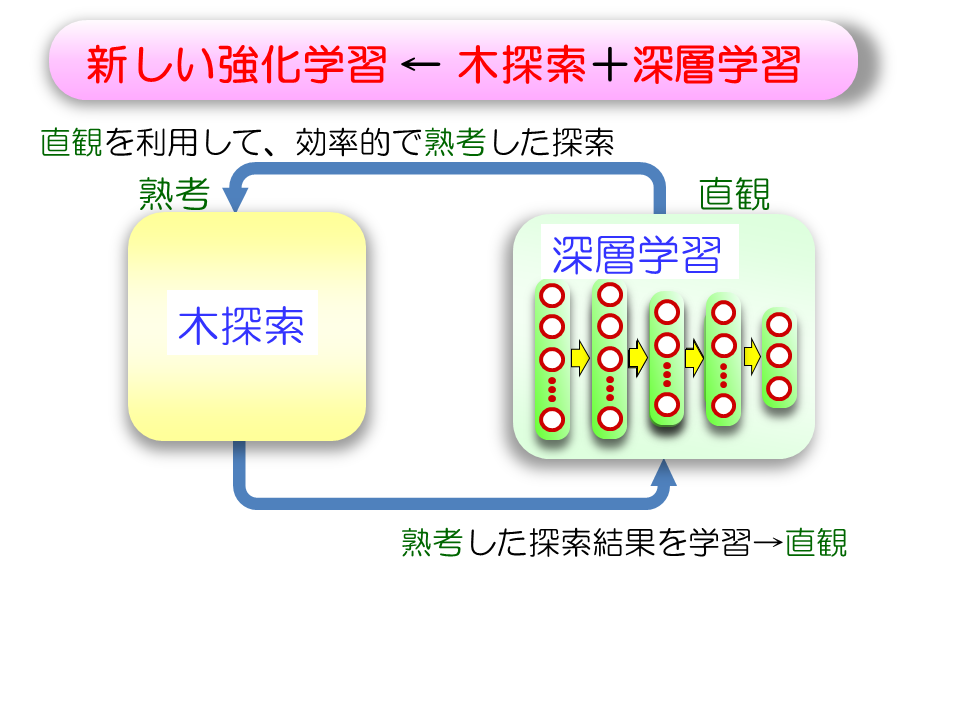

新しい強化学習

強化学習は、明確な教師信号が与えられないような場合に効果的な学習方式です。しかしながら非常に多い学習回数が必要という問題点があります。そこで、ニューラルネットワークによる深層学習での直観的な学習と探索アルゴリズムを用いた熟考的な探索を組み合わせることにより、学習特性を大きく向上させます。

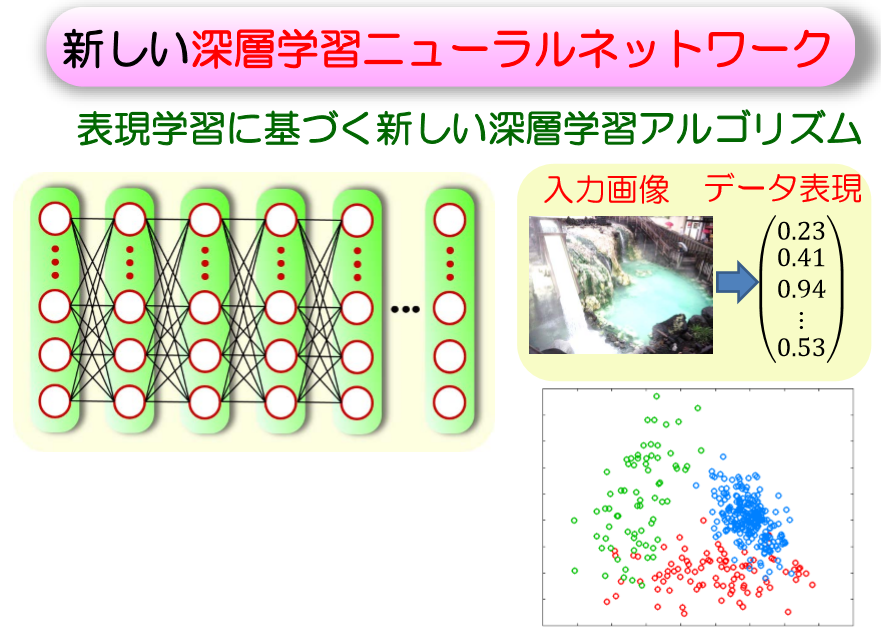

クラスタリングを応用した表現学習

パターン認識や物体検出といった機械学習のタスクを行う際、入力するデータをどのように表現するかによって大きく性能が変わることが知られています。

これまでの機械学習では、行うタスクに適したデータ表現を人手でいちいち選ぶ必要がありました。

そこで、表現学習という、良い性能を発揮するためのデータ表現をニューラルネットワークで自動的に学習させるという手法が近年発展してきました。

萩原研究室では、教師情報なしでデータの自動分類を行うことができる「クラスタリング」と呼ばれる手法を応用し、さまざまなタスクに汎用的に用いることができるデータの表現を学習する方法を研究しています。